DPO

Nuestros servicios

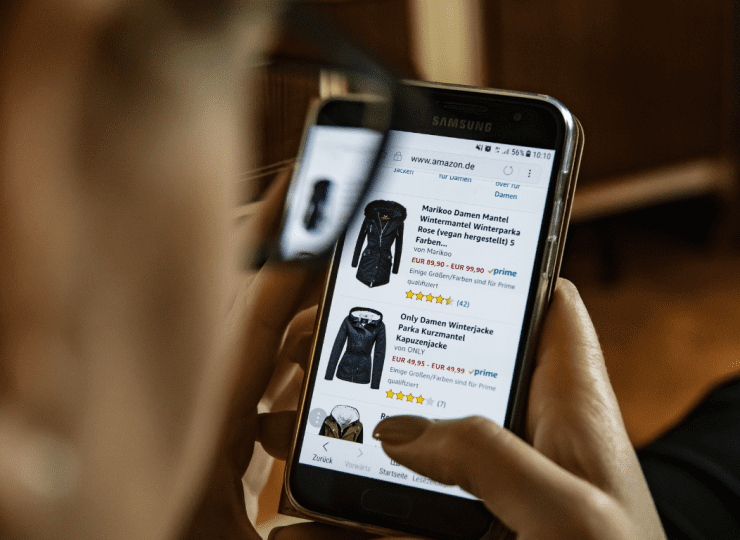

DPO externo para

tech y retail

Hemos trabajado con más de 60 clientes tech y retail en el EEE, Reino Unido, Estados Unidos y Australia y resuelto numerosos aspectos de protección de datos y privacidad con soluciones adaptadas a nuestros clientes, sus productos, equipos, procesos y sistemas.

Protección de datos a tu medida

El paquete perfecto para fundadores de startups y equipos legales que necesiten un soporte adicional. Podemos realizar una evaluación completa o parcial del modelo de negocio actual desde la perspectiva de protección de datos, actividades de tratamiento de datos y políticas para identificar los elementos de cumplimiento que pueden mejorarse y proponer una hoja de ruta.

Regulación de telecomunicaciones

Resolvemos las cuestiones más difíciles en el campo de regulación de telecomunicaciones. Trabajar con Aphaia otorga acceso a nuestra dilatada experiencia con la industria, que abarca desde el acceso a la infraestructura de red hasta los regímenes de licencias y autorización.

¿Por qué Aphaia?

- Somos un equipo de profesionales de la regulación de las TIC y la privacidad de datos, con gran experiencia con fundadores de startups y equipos legales y de operaciones de negocios multinacionales consolidados, en una variedad de sectores.

- Podemos comunicarnos de manera efectiva con cualquier persona en tu organización, desde ingenieros y desarrolladores de productos hasta equipos de marketing y recursos humanos.

- Nuestro enfoque global garantiza una identificación temprana de las últimas tendencias regulatorias y de aplicación en Europa, Reino Unido, Estados Unidos y otros mercados.

Wolf & Badger

Wolf & Badger necesitaba dar respuesta a los requisitos del RGPD en relación con los datos de sus clientes y sus diversas marcas y páginas web, colaboraciones y datos de empleados. Esto es lo que hicimos.

Necesito…

Lo que nuestros clientes dicen sobre nosotros